Последнее бновение - 19 февраля 2023 в 10:12

Эта заметка о том, как используется директива Clean-param в файле robots.txt. Посмотрим, на что она влияет.

Директива Clean-param является полезным инструментом, который может быть использован в robots.txt для управления бюджетом обхода веб-сайта и повышения его СЕО-эффективности. Директива предписывает сканерам поисковых систем игнорировать определенные параметры URL при обходе сайта, что может помочь уменьшить количество дублируемого контента и повысить эффективность обхода.

Во многих случаях веб-сайт может содержать несколько страниц с разными параметрами URL, но с одинаковым содержимым. Это способно вызвать проблемы у сканеров поисковых систем, поскольку они могут просматривать каждую страницу как отдельный URL-адрес и обходить каждую из них.

В свою очередь, это может привести к растрате ценного бюджета на сканирование и созданию проблем с дублированием контента. Однако, используя директиву Clean-param в файле robots.txt, можно решить данную проблему, указав роботу игнорировать параметры URL, которые не имеют отношения к содержимому страницы.

Каждому сайту поисковиками определён свой бюджет, от размера которого зависит скорость попадания страниц в поисковую выдачу. Это очень важно для крупных проектов.

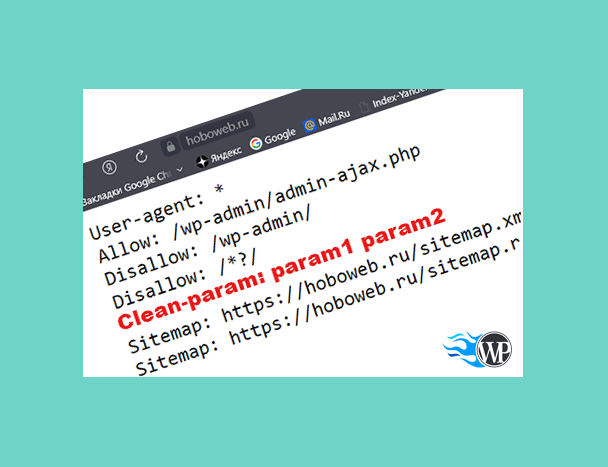

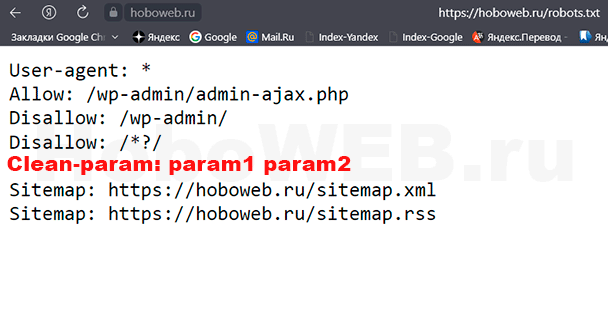

Синтаксис директивы Clean-param прост. За директивой следует список параметров URL, которые должны игнорироваться краулером поисковой системы. Например, если веб-сайт имеет URL-адреса, которые включают параметры «sort», «page» и «lang», то файл robots.txt может содержать следующую директиву:

Clean-param: sort page lang

Это подскажет поисковому роботу игнорировать данные три параметра при обходе сайта.

И ещё один вариант. Например, если на веб-сайте есть URL-адреса, которые выглядят следующим образом:

https://example.com/page?param1=value1¶m2=value2

и содержимое на этой странице является одинаковым, независимо от значений «param1» и «param2», тогда robots.txt файл может содержать следующую директиву:

Clean-param: param1 param2

Здесь «param1» и «param2» — это имена параметров URL, которые веб-сканер должен игнорировать. Это подскажет веб-сканеру игнорировать параметры «param1» и «param2» при обходе веб-сайта, помогая предотвратить проблемы с дублированием контента.

Когда я использую директиву Clean-param, то могу быть уверен, что краулинговый бюджет для моего веб-сайта расходуется эффективно, и что поисковые системы могут сосредоточиться на обходе и индексации наиболее важных страниц. Это может привести к повышению эффективности SEO, поскольку контент сайта с большей вероятностью будет должным образом проиндексирован и отображён на страницах результатов поисковой системы.

Важно отметить, что не все поисковые системы распознают директиву Clean-param. Например, Яндекс входит в число поисковых систем, поддерживающих эту директиву, но другие могут и не поддерживать. Что касается Google, то примерно с мая 2022 года данный поисковик автоматически определяет, какие параметры нужны на сайте, а какие нет.

Кроме того, стоит отметить: использование директивы не гарантирует, что указанные параметры URL будут проигнорированы поисковыми роботами. Однако использование директивы по-прежнему является полезным инструментом для управления бюджетом обхода и повышения его эффективности. Очень подробно работу Clean-param описывает Яндекс Справка.

В дополнение к директиве Clean-param существуют другие инструменты и методы, которые можно использовать для управления краулинговым бюджетом и повышения эффективности SEO. Например, я могу использовать директиву Disallow в файле robots.txt, чтобы запретить поисковым роботам получать доступ к определенным страницам или каталогам на сайте. Они также могут использовать тег rel=»canonical» в HTML-коде для указания предпочтительного URL для данной страницы, что может помочь предотвратить проблемы с дублированием контента.

В заключение хочу отметить, что директива Clean-param является ценным инструментом, который может помочь веб-мастеру управлять бюджетом обхода своего веб-сайта и повышать эффективность SEO. Указывая поисковым системам игнорировать определенные параметры URL, директива может помочь уменьшить количество дублирующегося контента и повысить эффективность обхода. Хотя не все поисковые системы поддерживают директиву, её использование в сочетании с другими инструментами и методами может помочь гарантировать, что веб-сайт должным образом проиндексирован и отображается на страницах результатов поисковой системы.

Видео

Всем удачи!