Последнее обновлене - 19 февраля 2023 в 10:19

Сегодня небольшая заметка о том, как создать файл robots.txt для сайта, работающего на CMS WordPress. Как при помощи входящих в его состав директив управлять поведением поисковых роботов.

Важность наличия роботс на сайте, на мой взгляд, неоспорима. Ведь недаром, WP-разработчики предусмотрели его присутствие в системе по умолчанию, как говорится, «из коробки».

Содержание:

Что такое robots.txt и где его найти

Robots.txt представляет собой текстовый файл, расположенный в корневой директории сайта, там же, где находится .htaccess и sitemap.xml. Данный файл влияет на индексирование веб-страниц поисковыми системами. При помощи специальных директив он запрещает или разрешает индексировать те или иные записи, это очень удобно.

Как создать и как корректировать robots.txt

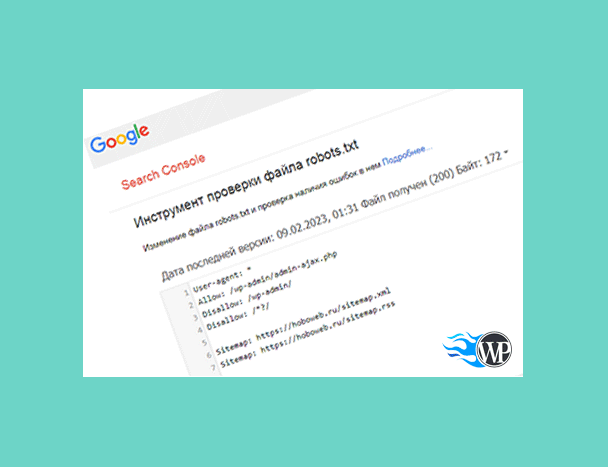

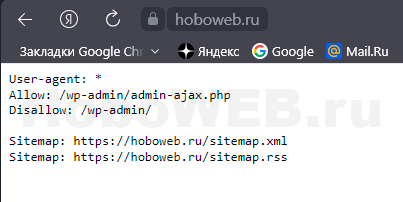

Надо отметить, что robots.txt сразу начинает работать по умолчанию, одновременно с установкой WordPress. И, по сути, изначально с ним ничего делать не надо. Если перейти по адресу https://nazvanie-saita.ru/robots.txt, то мы увидим вот такое содержание файлика, рекомендованное разработчиками CMS.

Очевидно, что рекомендовано скрыть от поисковиков раздел админки. Однако, обработчик запросов admin-ajax.php из этой же директории должен быть открыт для индексирования.

Как правило, этого бывает достаточно. Вмешиваться в работу robots.txt следует в том случае, если, к примеру, вебмастер фиксирует наличие дублированного контента. Тогда идут в ход запрещающие директивы Disallow.

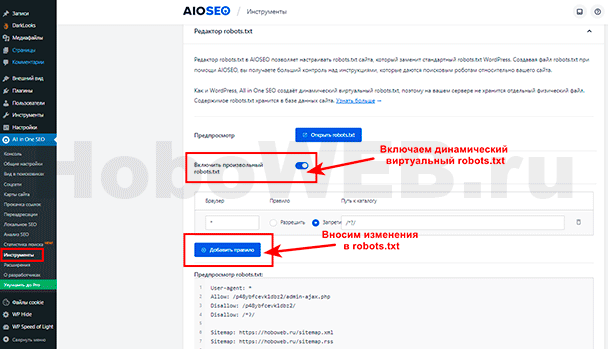

Чтобы провести корректировку файла, можно пойти двумя путями. Изменения вносятся либо при помощи создания физического файла, размещаемого в корне сайта, либо включением соответствующей функции плагина.

Я, к примеру, использую СЕО-плагин All in One SEO, в котором реализована возможность внесения изменений в файл robots.txt, включения его в работу. Ранее, у меня был установлен физический файл в корневой директории сайта. Его лучше сразу удалить, если включаем динамический виртуальный robots.txt плагином.

Основные директивы robots.txt

Какие же основные директивы или указания применяются для поисковых систем? Их немного, очень просто запомнить:

- User-agent — обозначает робота конкретной поисковой системы, на которого распространяются правила (к примеру, Yandex, но не только).

- Allow — разрешает обход и индексирование роботами веб-страниц, папок и файлов.

- Disallow — запрещает всё то же самое, что и в предыдущем пункте.

- Clean-param — сообщает роботу, какие параметры URL не надо учитывать при индексировании (к примеру, это могут быть UTM-метки).

- Sitemap — указывает путь к файлу Sitemap.

Здесь надо отметить, что все вышеперечисленные директивы подходят для всех поисковиков, кроме Clean-param, которую понимает только Яндекс.

Если иным образом не закрыты от индексации системные директории и файлы, а также параметры URL, то их рекомендуется запретить для обхода поисковыми роботами. Это могут быть:

- /wp-admin — админпанель.

- /wp-json — JSON REST API.

- /xmlrpc.php — протокол XML-RPC.

Или, например, такие параметры:

- s — стандартная функция поиска.

- author — личная страница пользователя.

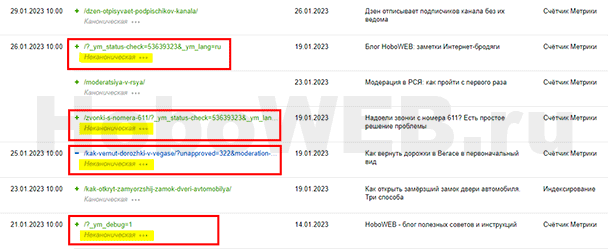

Недавно, в панели Яндекс.Вебмастер я заметил присутствие дублированного контента. Были проиндексированы некоторые URL с параметрами. Для того, чтобы от них избавиться, я включил запрещающую директиву: Disallow: /*?/.

Пример правильного robots.txt

Иногда применяют вариант раздельного содержимого файла robots.txt для более гибкой настройки индексации. То есть, вписывают директивы отдельно для Яндекса и отдельно для остальных поисковиков. Делается это для того, чтобы исключить лишние «телодвижения» поисковых роботов. К примеру, зачем Яндексу сканировать AMP-страницы, которые он не поддерживает?

В этом случае правильный robots.txt может выглядеть следующим образом:

User-agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /xmlrpc.php

Disallow: /wp-admin

Disallow: /wp-json

Disallow: /*?

User-agent: Yandex

Allow: /wp-admin/admin-ajax.php

Disallow: /xmlrpc.php

Disallow: /wp-admin

Disallow: /wp-json

Disallow: /*?

Disallow: /amp

Sitemap: https://vash-supersite/wp-sitemap.xml

Существует возможность ещё более тонкой настройки индексации страниц сайта с параметрами посредством файла robots.txt. Делается это при помощи директивы Clean-param. С ней работает поисковик Яндекс.

Как проверить robots.txt

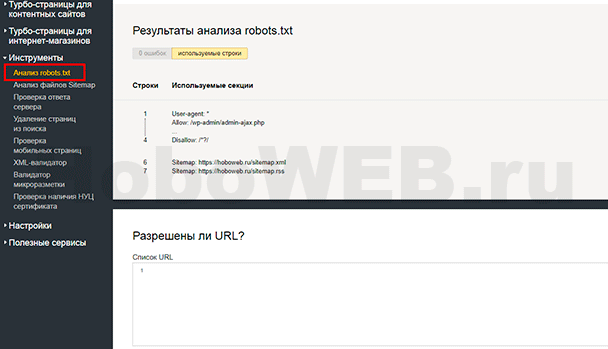

Правильность работы robots.txt можно проверить в настройках Яндекс.Вебмастер, в разделе «Инструменты». Здесь можно проверить любую страницу, открыта или закрыта она от индексации.

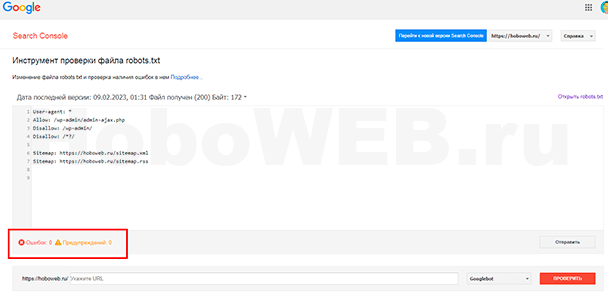

Кроме того, подобную проверку можно выполнить и в Google, в старой версии Search Console, по ссылке: https://www.google.com/webmasters/tools/robots-testing-tool. В новой версии Search Console, к сожалению, этот функционал пока не реализован.

Видео

Видео, конечно, не по теме. Но лучше, если оно тут будет.

Всем удачи!