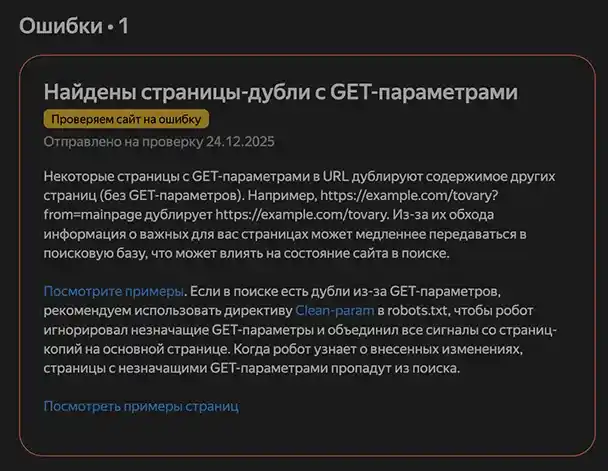

Приветствую, уважаемый веб-мастер! Вы только что получили от Яндекс.Вебмастера то самое тревожное письмо, которое заставляет даже самых стойких оптимизаторов пойти и задумчиво попить кофе ☕. «Найдены страницы-дубли с GET-параметрами!» — звучит как приговор из мира киберпанка.

Ваш сайт, ваше цифровое дитя, внезапно начал плодить клонов, и все они жаждут внимания поисковых систем. Расслабьтесь. Сейчас мы разберемся, кто эти непрошеные гости, откуда они взялись и как вернуть им единство разума.

🤷♂️ Что это за зверь и почему он выбрал МОЙ сайт?

Страницы-дубли с GET-параметрами — это не ошибка кода, а побочный эффект вашей популярности. Представьте: каждая ваша статья — это блистательная картина в галерее. А GET-параметры (вроде ?_utl_t=vk или ?epik=джунгли_из_букв) — это просто стикеры, которые кто-то наклеил на раму при переносе из одной соцсети в другую.

Для вас и ваших читателей — одна и та же картина. Для робота Яндекса, который педантично сканирует каждый миллиметр, — это уже десятки разных картин со стикерами из ВК, WhatsApp и прочих digital-джунглей.

Почему именно ваш сайт? Потому что вы — активный участник цифрового базара! Вы или ваш маркетинг-автопилот делитесь статьями через сервисы, которые автоматически цепляют свои метки-хвостики. А потом в вашем robots.txt скрывался секретный агент — строка Disallow: /*?*.

Она, как суровый привратник, не пускала робота внутрь, чтобы тот убедился, что под стикерами — один контент. Вместо понимания робот фиксировал хаос. На других ваших сайтах этой ошибки нет просто потому, что там либо меньше шума от «грязных» ссылок, либо привратник был менее строг.

🛠️ Рецепт избавления от клонов: магия Clean-param

Вам нужен точечный, элегантный инструмент — директива Clean-param в файле robots.txt. Это как выдать умному роботу-уборщику (именно Яндексу) волшебный растворитель, который стирает только определенные стикеры (_utl_t, epik, все utm), не трогая сам шедевр.

Пошаговый план операции:

- Откройте ваш robots.txt (обычно в корне сайта).

- Найдите и УДАЛИТЕ строку Disallow: /*?*. Да, просто удалите. Она сыграла свою негативную роль. 👋

- Добавьте в КОНЕЦ файла, прямо перед Sitemap, магический код:

12User-agent: YandexClean-param: _utl_t&epik&utm_source&utm_medium&utm_term&utm_content&utm_campaign /

- Сохраните файл. Ваш приказ записан. ✨

Что теперь произойдет? Робот Яндекса получит инструкцию: «Игнорируй хвостики _utl_t и epik, а все твиты, лайки и авторитет с этих версий страниц приписывай чистой, канонической версии». Сигналы объединятся, дубли — исчезнут из поиска, а сила вашего основного URL — возрастет. Это и есть та самая цифровая гигиена.

💎 Вывод: не бойтесь, а управляйте

Эта ошибка — не критика, а комплимент вашей активности. Яндекс просто предложил вам перейти на следующий уровень управления своим цифровым пространством. Больше не нужно грубо блокировать всё. Научитесь изящно объяснять роботам правила игры на вашей территории.

Сделайте это сегодня. А через неделю зайдите в Яндекс.Вебмастер и с улыбкой наблюдайте, как список клонов тает, словно снег под утренним солнцем цифровой оптимизации. Ваш сайт снова станет цельным, уникальным и готовым к новым свершениям! 🚀

P.S. И да, если на других сайтах живет тот же строгий привратник (Disallow: /*?*), прогоните его и оттуда. Залог спокойствия — не в тотальной блокировке, а в умном диалоге с миром роботов.